Google’da görünmüyor olmak sinir bozucu olabilir ama çoğu zaman çözüm, birkaç temel noktayı sistemli biçimde kontrol etmekten geçer. Sitenizin taranıp taranmadığı, sayfaların gerçekten indekslenebilir olup olmadığı, JavaScript ile yüklenen içeriklerin Googlebot tarafından görülebilirliği, içerik kalitesinin insanların aradığı bilgiye gerçekten cevap verip vermediği ve sayfa deneyiminin Core Web Vitals ölçümlerinde yeterli seviyede olması gibi faktörler sıralı bir denetimle açıklığa kavuşur.

Buna ek olarak manuel işlem, güvenlik uyarısı, yanlış robots.txt veya hatalı kanonik etiket gibi görünürlüğü bastıran teknik ayrıntılar da tabloyu değiştirebilir. Bu yazıda, keşiften indekslemeye, içerik faydasından kullanıcı deneyimine ve Search Console pratiklerine kadar adım adım ilerleyerek sitenizin neden Google’da çıkmadığını teşhis etmenize ve doğru müdahaleleri yapmanıza yardımcı olacağız.

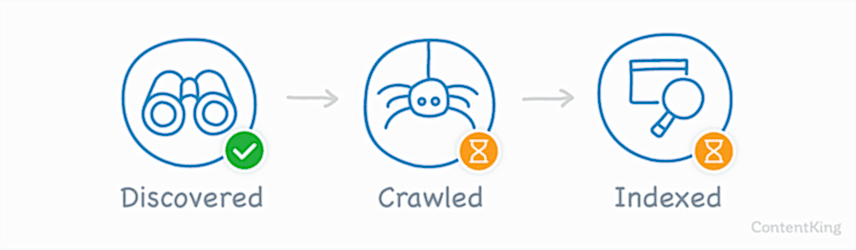

1. Google sitenizi keşfedebiliyor mu? (Crawling)

Google’da görünürlüğün ilk eşiği keşiftir. Googlebot sitenize erişemiyor, tarama isteğini engelleyen kurallar varsa veya sunucu hataları veriyorsa, gerisi gelmez. Aşağıdaki alt başlıklarda, taramayı bloke eden tipik durumları bulacaksınız.

robots.txt yanlış kullanımı sitenin taranmasını engelliyor mu?

/robots.txt içindeki geniş kapsamlı Disallow kuralları, Googlebot’un sitenizi görmesini tamamen durdurabilir. İçerik sayfaları açık, yalnızca yönetim/oturum ve tekrar eden düşük değerli yollar kapalı olmalı. CSS/JS gibi kritik kaynakları engellerseniz Google sayfayı gerektiği gibi işler/render edemez; bu da kalite ve indeksleme kararını olumsuz etkiler. Dosyanın 200 durum kodu verdiğini ve güncel sürümün servis edildiğini doğrulayın; Sitemap: satırıyla haritanızın yolunu belirtin.

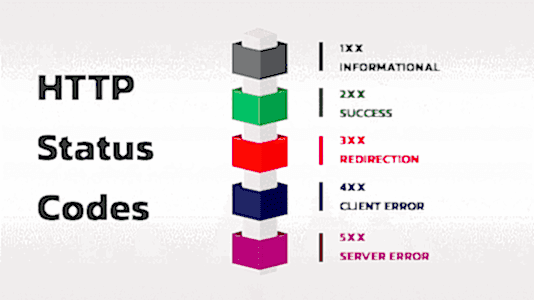

Sunucu yanıtları (5xx/4xx), IP kısıtları veya oturum duvarı var mı?

Yoğunluk anlarında 5xx hataları, WAF/CDN’in Googlebot’u engellemesi ya da “giriş yapmadan içerik yok” gibi bariyerler keşfi keser. Hata oranlarını düşürün, Googlebot’u allowlist’e alın, önemli içerikleri oturum arkasından çıkarın. Kalıcı taşımalarda 301 kullanın, gereksiz yönlendirme zincirlerini kısaltın ve TTFB’yi iyileştirerek tarama hızını artırın.

Site haritası (sitemap) Google’a gönderildi mi ve güncel mi?

Sitemap yalnızca 200 dönen, kanonik ve indekslenebilir URL’leri içermeli. Büyük sitelerde haritayı mantıksal parçalara bölün (ör. içerik türüne göre). İçerik güncellemelerinde lastmod alanını gerçek değişime göre yenileyin ve haritayı Search Console’a göndererek hataları düzenli takip edin.

Dahili bağlantı yapısı keşfi kolaylaştırıyor mu?

Yetim (orphan) sayfalar keşfi zorlaştırır. Öncelikli sayfalarınız ana menüden, kategori sayfalarından ve ilgili içeriklerden metin tabanlı bağlantılarla desteklenmeli. Tıklama derinliğini azaltın; kritik sayfalara 2–3 adımda ulaşılabilsin. Bağlantı metinlerini (anchor) açıklayıcı tutarak Google’a içerik bağlamını net verin.

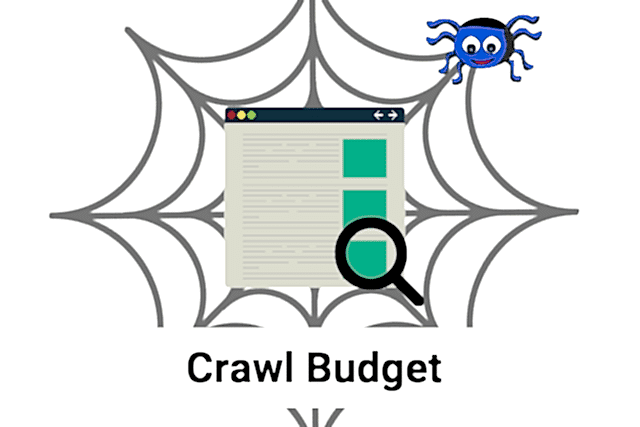

Parametreli URL’ler ve filtreler tarama bütçesini tüketiyor mu?

Renk/sıralama/sayfalama gibi parametreler çok sayıda benzer URL üreterek tarama bütçesini eritir. Tercih edilen URL’yi kanonik olarak işaretleyin, düşük değerli liste/arama sayfalarını noindex ile sınırlandırın ya da üretimlerini kısıtlayın. Sitemap’te yalnızca tercihli (kanonik) URL’ler yer alsın.

Büyük sitelerde tarama bütçesi (crawl budget) nasıl yönetiliyor?

Yüzbinlerce düşük değerli URL yerine, sık güncellenen ve iş hedefi yüksek sayfaları öne çıkaran bir mimari kurun. Sunucu performansını artırın, gereksiz varyant üretimini azaltın, önemli URL’lere güçlü dahili bağlantı ve güncel sitemap görünürlüğü sağlayın. Bu, Googlebot’un tarama enerjisini doğru sayfalara yönlendirir.

2. Sayfalarınız indekslenebilir mi?

noindex, kanonik ve yönlendirme çakışıyor mu?

Bir sayfanın indekslenmesini istiyorsanız 200 durum kodu dönmeli, noindex içermemeli ve kendi kanonik etiketine işaret etmelidir. 301’le başka bir sayfaya taşıyorsanız hedef sayfa da kendini kanoniklemeli. Karışık sinyaller (noindex + canonical, 302’ler, zincirli yönlendirmeler) Google’ın dizine eklemeyi bırakmasına yol açabilir.

“Crawled – currently not indexed” ne anlama gelir?

Google sayfanızı görmüştür ama henüz dizine eklemeye değer bulmamıştır. Genellikle içerik değeri düşüktür, çok benzer kopyalar vardır ya da site içi bağlantılar zayıftır. Konu kapsamını derinleştirmek, benzer URL’leri konsolide etmek ve önemli sayfalara daha görünür dahili linkler vermek çoğu zaman sorunu çözer.

Yinelenen içerik ve parametre enflasyonu

Renk/sıralama/sayfalama gibi parametreler aynı içeriğin onlarca kopyasını üretebilir. Tercih edilen URL’yi kanonik etiketle netleştirin; filtre/arama sayfalarını mümkünse noindex yapın. Site haritasında yalnızca kanonik ve 200 dönen URL’ler bulunsun.

HTTP durum kodları ve “soft 404”

Gerçekte olmayan veya çok zayıf içerikli sayfalar 200 dönse bile “soft 404” olarak algılanabilir. Hata sayfaları gerçekten 404/410 dönmeli; kalıcı taşımalarda 301 kullanın. Boş/ince sayfaları ya güçlendirin ya da ilgili, güçlü bir sayfayla birleştirin.

İnce içerik, doorway sayfalar ve kalite sinyali

Sadece şehir adı veya anahtar kelime değişerek çoğaltılan sayfalar kullanıcıya değer sunmaz. Tek, kapsamlı ve özgün kanıtlarla (veri, görsel, örnek) zenginleştirilmiş içerikler üretin. Yazar/kurum bilgisi, güncelleme tarihi ve açık kaynakça güven sinyallerini artırır.

Çok dilli sitelerde hreflang–kanonik uyumu

Her dil/bölge sürümü kendi kendine kanonik olmalı ve hreflang etiketleri karşılıklı (return) eşleşmelidir. Yanlış eşleşmeler Google’ın yanlış sürümü göstermesine veya hiç indekslememesine sebep olabilir.

Yapısal veri (schema) tek başına yeterli değildir

Schema, içeriği anlamayı ve zengin sonuçları kolaylaştırır ama indeksleme kararı; teknik uygunluk, içerik değeri ve kullanıcı işaretlerinin toplamıdır. Önce içerik ve teknik temeli sağlamlaştırın, ardından schema’yı doğru uygulayın.

Search Console ile hızlı tanı

URL Denetimi’nde dizindeki sürüm ile canlı testi karşılaştırın; Page Indexing raporundaki durum açıklamalarını izleyin; site haritasında yalnızca tercihli URL’lerin listelendiğini doğrulayın. Kritik sayfalar için düzeltmeden sonra yeniden tarama isteyebilirsiniz.

3. İçerik yardımcı ve güvenilir mi? (E-E-A-T / Helpful Content)

Kullanıcı niyetiyle birebir örtüşen, özgün içgörü sunan ve somut kanıtlarla desteklenen içerik Google için “yardımcı” kabul edilir. Soruyu doğrudan yanıtlayın, ardından ayrıntıya inin: tanım → kısa cevap → kanıt/örnek → uygulanabilir adımlar. Gereksiz dolgu metinden kaçının; her paragraf okurun işini kolaylaştırmalı.

Uzmanlık ve deneyim (Experience/Expertise). Konuyu bizzat yapmış, ölçmüş, test etmiş olduğunuzu gösterin: süreç ekran görüntüleri, kendi ölçtüğünüz metrikler, vaka/örnek, müşteri senaryosu. Yazar biyografisi, unvan ve sorumlu ekip bilgisi güven oluşturur.

Yetkinlik ve doğruluk (Authoritativeness/Accuracy). Tanımlar, veriler ve yöntemler güncel olmalı. Mümkün olduğunda birincil kaynaklara atıf yapın (ör. standartlar, yönergeler). Tarih damgası ve “son güncelleme” ibaresi ekleyin; tarihli görseller/tablolarda versiyon belirtin.

Güven (Trust). İçerik boyunca şeffaf olun: şirket/iletişim sayfası, iade/garanti ve gizlilik politikaları görünür olsun. Ücretli ortaklıklar, sponsorluklar ve afiliye linkleri açıkça işaretleyin. Teknik tavsiyelerde risk ve sınırlılıkları belirtin.

Benzersizlik ve derinlik. İlk sayfadaki rakiplerle aynı cevapları tekrarlamak yerine farklılaştırıcı bir “mekanizma” sunun: özgün kıyas tabloları, karar ağaçları, mini checklist yerine adım adım akış , indirilebilir şablon veya hesaplama mantığı. Tek bir sayfada “herkese” yazmak yerine bir avatara odaklanın.

Okunabilirlik ve deneyim. Net başlık hiyerarşisi (H2/H3), kısa cümleler, açıklayıcı alt başlıklar, anlamlı görsel/şema kullanımı. Mobilde hızlı açılan, reklam/overlay ile bölünmeyen sayfa deneyimi; kritik bilgiyi sayfa üstünde sunun.

Arama amacı uyumu. Sorgunun tipi (bilgilendirici/karşılaştırmalı/işlemsel) ile içerik formatını eşleyin. “Nasıl yapılır?” için adımlar ve görsel; “karşılaştırma” için kriter matrisi; “satın alma” için açık teklif, kanıt ve CTA.

Şeffaf yapı. Kim yazdı? Hangi yöntemle test edildi? Hangi veriye dayanıyor? Yanıtın kapsamı neyi içermiyor? Bu sorulara içerik içinde kısa, görünür cevaplar verin. Bu yaklaşım hem kullanıcıya değer katar hem de E-E-A-T sinyallerini güçlendirir.

4. Sayfa deneyimi ve Core Web Vitals

İyi içerik tek başına yetmez; hız, stabilite ve etkileşim kalitesi görünürlüğü ve dönüşümü doğrudan etkiler. Google’ın temel metrikleri:

- LCP (Largest Contentful Paint): En büyük ana içerik öğesinin görünmesi. ≤2,5 sn iyi.

İyileştirme: Görselleri sıkıştırın/uyarlayın (WebP/AVIF),preloadile kahraman görseli/ana fontu önden çağırın, kritik CSS’i satıriçi verin, TTFB’yi düşürün (CDN, caching). - CLS (Cumulative Layout Shift): Beklenmeyen kaymalar. ≤0,1 iyi.

İyileştirme: Tüm görsellere/video iframelarına genişlik–yükseklik veyaaspect-ratioatayın, reklam/yerleşim boşluklarını sabitleyin, geç yüklenen bileşenler için iskelet kullanın. - INP (Interaction to Next Paint): Etkileşime verilen genel yanıt süresi. ≤200 ms iyi.

İyileştirme: Ağır JS’yi bölün (code-split),defer/asynckullanın, üçüncü taraf scriptlerini azaltın, pahalı event handler’ları optimize edin (debounce/throttle), ana iş parçacığını boşaltın (Web Worker).

Ölçüm ve takip:

- Gerçek kullanıcı verisi (field): Search Console’daki Core Web Vitals raporunu ve CrUX verisini temel alın (cihaz/ağ koşulları gerçeği yansıtır).

- Laboratuvar testleri (lab): Lighthouse/Pagespeed Insights ile yerel hataları yakalayın; ancak kararları her zaman field veri önceliğiyle verin.

Ek deneyim sinyalleri:

- HTTPS, temiz URL’ler, mobil uyumlu tasarım, aşırı müdahaleci pop-up kullanmama, istikrarlı yönlendirmeler.

- Kaynak yönetimi: Kritik yolu daraltın (preconnect/dns-prefetch), font görüntülemede

font-display: swap, kullanmadığınız CSS/JS’yi ayıklayın.

Özetle, LCP hızlı, CLS sabit, INP çevik olduğunda hem arama görünürlüğü hem de kullanıcı memnuniyeti belirgin şekilde artar.

5. Yeni site veya düşük keşfedilebilirlik durumları

Yeni açılan sitelerde görünürlük gecikmesi normaldir; Google’ın sizi tanıyıp düzenli taraması için keşif sinyallerini güçlendirmeniz gerekir. Önce Search Console’da alan adını doğrulayın, XML sitemap’i ekleyin ve kritik sayfalar için URL Denetimi → Dizine eklenmesini iste akışını kullanın. “Discovered/Crawled but not indexed” durumlarında, benzer sayfa yığınlarını konsolide edin; tekil, değerli içerikleri öne alın.

Dahili bağlantı keşfi hızlandırır: ana menü, kategori ve ilgili yazılardan öncelikli sayfalara net, metin tabanlı linkler verin; tıklama derinliğini 2–3 seviyede tutun. Gereksiz parametre/etiket/arama sayfası üretimini sınırlayın; sitemap’te yalnızca kanonik ve 200 dönen URL’ler bulunsun. Statik dosyalar ve HTML hızlı yanıt vermeli (TTFB), önemli içerik JS’ye bağımlı kalmamalı.

Dış dünyadan doğal keşif sinyalleri sağlayın: marka sayfaları (Hakkımızda/İletişim), açık şirket bilgisi, yerel dizin/profil kayıtları, alakalı sitelerden atıf alan kaynak niteliğinde içerikler. Sosyal paylaşımlar tek başına sıralama sinyali olmasa da yeni URL’lerin bulunmasına yardımcı olabilir. Düzenli yayın takvimi ve güncel lastmod alanları tarama talebini canlı tutar.

Kısacası, yeni veya az bilinen sitelerde başarı; teknik erişilebilirlik + güçlü dahili mimari + gerçekten faydalı, benzersiz içerik üçlüsüne erken dönemde yatırım yapmaktan geçer.

6. Politika ihlalleri, Manual Actions ve görünürlük kaybı

Google’ın Spam ve Arama Politikaları ihlal edildiğinde, siteniz Manual Action (Manuel İşlem) alabilir ve görünürlüğünüz dramatik biçimde düşer. Manuel işlem; bir inceleme ekibinin sitenizde manipülatif bağlantılar , gizleme (cloaking), sinsi yönlendirme, otomatik üretilmiş/ince içerik, schema suistimali, zararlı içerik gibi ihlaller bulmasıyla uygulanır. Sonuç; tekil sayfaların bastırılması, belirli özelliklerin (zengin sonuçlar) kaldırılması veya tüm sitenin ciddi trafik kaybıdır.

Önce Search Console > Manual actions (Manuel İşlemler) bölümünü kontrol edin. Bildirim varsa, mesajda belirtilen ihlali gerçek örneklerle eşleştirin: örneğin bağlantı şemaları için dış bağlantı profili ve ücretli/karşılıklı link izleri; cloaking/sneaky redirect için kullanıcı ve Googlebot’a sunulan içerik farkları ; yapılandırılmış veri suistimali için işaretlediğiniz alan–sayfa içeriği uyuşmazlığı . Şüpheli URL’ler, enjekte edilmiş anahtar kelimeler ve zararlı dosyaları tarayın.

Düzeltme, yalnızca “sorunlu parçayı” değil kök nedeni hedeflemeli: yapay bağlantıları kaldırın veya rel="nofollow/sponsored" ile işaretleyin, gizli metin/yönlendirme/kapı sayfalarını tamamen kaldırın, otomatik üretilmiş kopyaları konsolide edin ve schema’yı gerçek içerikle uyumlu hâle getirin. Güven problemi yaşandıysa şeffaflığı artırın (yazar/kurum bilgisi, güncelleme tarihi, açık kaynaklar).

Tüm temizliği belgeledikten sonra yeniden değerlendirme talebi gönderin: neyin yanlış olduğunu, nasıl tespit edip düzelttiğinizi ve tekrarını önlemek için hangi süreçleri kurduğunuzu net ve dürüst biçimde anlatın. Manuel işlem kaldırılabilir; ancak algoritmik düşüşlerde (ör. kalite düşüklüğü, kullanıcı memnuniyetsizliği) mesaj gelmez—çözüm, genel kalite ve deneyimi iyileştirmektir. En iyi savunma, ilk günden itibaren politika uyumu ve kullanıcıya gerçek değer sunmaktır.

7. Güvenlik sorunları ve uyarılar

Siteniz zararlı yazılım (malware) , istenmeyen yazılım veya zararlı içierik barındırıyorsa Google görünürlüğünüzü sınırlayabilir, hatta kullanıcılara uyarı gösterebilir. İlk durak Search Console > Security Issues (Güvenlik Sorunları) bölümüdür; burada saldırı türü ve örnek URL’ler listelenir.

Ne oluyor?

Saldırganlar genellikle gizli yönlendirmeler ekler, JS içine kötü amaçlı kod enjekte eder, spam sayfalar üretir veya formlarla kimlik avı yapar. Bu içerikler fark edilirse tarama sıklığı düşer, bazı sayfalar dizinden çıkar ve kullanıcı tarafında “Bu site güvenli değil” uyarıları görülebilir.

Nasıl ele almalı?

- Hemen izolasyon: Sunucuyu yalnızca yönetici IP’lerine açın, şüpheli dosyaları ve son değişiklikleri tespit edin, güncel yedekten geri dönmeyi değerlendirin.

- Kaynak taraması: CMS çekirdeği/eklentiler/temalar için bütünlük kontrolü yapın; güncellemeleri uygulayın. .htaccess/Nginx kuralları, cron görevleri ve beklenmedik admin hesaplarını denetleyin.

- Temizlik ve doğrulama: Enjekte kodu kaldırın, zararlı URL’leri silin veya 410/404’a düşürün; şifreleri ve anahtarları (DB, API) değiştirin.

- Yeniden inceleme: Search Console’da sorunu çözdükten sonra “İnceleme iste” gönderin; neleri sildiğinizi ve nasıl önlemler aldığınızı kısaca açıklayın.

Önleyici temel adımlar

- HTTPS ve sertifika sağlığı: Tüm sayfalar kalıcı 301 ile HTTPS’e zorlanmalı; karışık içerik (mixed content) bırakmayın.

- Güvenlik başlıkları: HSTS, CSP, X-Frame-Options, X-Content-Type-Options, Referrer-Policy gibi başlıkları yapılandırın.

- Erişim ve yetkilendirme: Güçlü parolalar/MFA, sınırlı eklenti kullanımı, düzenli yedek ve günlük (log) izleme.

- WAF/CDN kuralları: Bilinen istismar vektörlerini filtreleyin; yönetim panellerini IP’ye göre kısıtlayın.

Kısacası, güvenlik uyarıları yalnızca kullanıcı güvenliğini değil, indekslenme ve sıralama sağlığınızı da etkiler. Olgun bir yama–yedek–izleme süreci ve proaktif başlık/HTTPS politikaları, görünürlüğünüzü korumanın en hızlı yoludur.

Arıza tespiti için Search Console Aracı

URL Denetimi (URL Inspection). Tekil bir sayfanın dizindeki sürümünü ve canlı testi karşılaştırın. Render edilmiş HTML’de kritik metin/link görünüyor mu, hangi kanonik seçilmiş, engelleyen robots/noindex var mı—hepsini burada görürsünüz. Düzeltmeden sonra kritik sayfalar için dizine eklenmesini isteyin.

Page Indexing (Dizin Kapsamı). “Crawled/Discovered but not indexed”, “Duplicate/Alternate canonical”, “Soft 404” gibi durumların örnek URL’lerini inceleyin; kök neden (zayıf içerik, kanonik çakışması, parametre enflasyonu, durum kodu hatası) bu rapordan çıkar.

Sitemaps. Sadece 200 ve kanonik URL’leri içeren haritaları gönderin; hata/uyarıları buradan takip edin. lastmod alanlarının gerçek değişiklikle güncellendiğinden emin olun.

Core Web Vitals. LCP/CLS/INP metriklerini alan verisi (field/CrUX) ile görün. Hız–stabilite–etkileşim sorunları genelde burada ortaya çıkar; iyileştirmeyi önceliklendirmek için etkilenen URL gruplarına bakın.

Crawl stats (Tarama istatistikleri). Googlebot’un istek hacmi, yanıt kodları, ortalama TTFB ve sunucu hataları bu raporda. 5xx artışı, yönlendirme zincirleri veya yavaş yanıtlar keşfi frenler.

Manual actions & Security issues. Görünürlükte ani düşüşlerde önce buraya bakın. Manuel işlem bildirimi varsa ihlal türünü (bağlantı şemaları, cloaking, yapılandırılmış veri kötüye kullanımı vb.) örnek URL’lerle eşleştirip düzeltin; güvenlik uyarılarında temizlikten sonra inceleme isteği gönderin.

Removals (Kaldırmalar). SERP’ten geçici kaldırma isteklerini ve noindex/kanonik yüzünden bastırılan URL’leri kontrol amaçlı doğrulamak için kullanın (kalıcı çözüm teknik tarafta).

Rich results & Enhancements. Ürün, SSS, HowTo gibi zengin sonuçların uygunluk ve hata durumları; schema kaynaklı görünürlük kayıpları burada yakalanır.

Links (Bağlantılar). Dahili bağlantı mimarinizin gerçekliğini ve dış bağlantı profilini görün. Önemli sayfalar yeterince iç link alıyorsa keşif ve indeksleme hızlanır.

Pratik akış. Sorunlu bir URL seçin → URL Denetimi ile canlı/dizin farkını görün → ilgili rapora gidip kök nedeni çözün (Indexing/CWV/Crawl stats) → düzeltin ve yeniden tarama isteyin → 1–2 hafta içinde raporları yeniden kontrol edin.

Kaynakça